Парсинг картинок на php

Содержание:

- Скачивание картинок по ссылке#

- Парсеры поисковых систем#

- Результаты#

- Парсеры сайтов в зависимости от используемой технологии

- Популярные парсеры для SEO

- Парсеры сайтов по способу доступа к интерфейсу

- await this.cookies.*#

- Проблема урлов картинок и ссылок

- Виды парсеров по технологии

- async processConf?(conf)#

- Парсинг – что это значит и как парсить сайты?

- Виды парсеров по сферам применения

- Зачем нужны парсеры

- Парсите страницы сайтов в структуры данных

- Возможные настройки#

- static parserOptions#

Скачивание картинок по ссылке#

A-Parser позволяет использовать цепочку заданий, по завершению первого, начнется выполнение второго, в качестве запросов для второго задания будут ссылки из первого

Скачать пример

eJyNVk1T2zAQ/SuMJofQgm0604svNKGlpUMJhXAKdEaNN65AlowkAxmT/95d2bHj

YGhv3tVqP98+uWSO2zt7bsCCsyyelSz33yxmX7VOJeyMlyLjKex81o9Kap6wPZZz

Y8GQ+YxdfonjyjKOx8sTMkWLBBa8kI7tlcwtc0Bv+gGMEQkdigTl3OinpQFnBFjU

PXBZkNlBFLHVzc0ewyzQgT3WJuOUzSA/COrUmsNL/gBTjYcLIaFVH6N0xjNyN0i4

AzoNFt7RcDdwT+SBJ4lwQisuqwhUTBv1Sol7n47F/FSK9ihSpsdGZ6h24J2QcrnO

cMYGXmbopvD3f1Z3WLzg0sIes5juMcdkku0T4cBwp80kp5xQXzKtRlKewgPI1sz7

HxdCJtj90QIvndQX+00mL3ysmhI3Q+FoHg3m0Hjx0njyo72V6FOdYuXJb6xbikw4

lO2RLhQNJ0LlHUDe9O1MoybTBpowzhTQBEe85aAIBu3URnmr6lTRmUxXOddqIdJJ

Da21ZaGmCOqJOtJZLoHKYh6XtsEwGAxSWLhoATOy9VBIaNLddnXkA1If1gBnTmtp

v19WiedGIB4/UroZtnUzh7q1cy7l1cVpJ7sWXyj8cS63cRjy/WrNgrnOQpGlodSp

3uf5pw9PQe4xOUdspxoRh2WvcNN6CleFlH174VfahhViA1Vk+4Oy/kaDVUDbVmF8

c9fPwMXxt+n0vLvh3Bi+rB37eabwNK22Xqxl/MZhOVBunwghDt4d+hzCIdbyfJvD

YfqcisUuNbS6Oi+s01k1oRYltGeUWIOIOtBC8taKugjcw4T6suYWpRWxhPaQpOUG

Zdt4yBLO46L6qP0q7eC+4HLTN8X3HNW7B30Q72WP/wHXmxiN2rVUegsPrwLtFep8

hQ+3F7FkVhdmTr4qsiP800wINtVQ+ocfDme/wpv3u9fXwfAw7s580A6hMl+9wv9I

5ryfMJpHq3fRu2wc9XFVs7jtIrJexo62Nr6XlzrMF718Vvy4XlJE9O+XIHr7Fdg+

7rwA0eqNJ6ufSt96K6LNd4J8+4bjQA5ofjVvNH8WZe+fQlzivZZWUET51p5Xlwnm

trLBsNZv7cHqL+EHA0s=

Скопировать

Парсеры поисковых систем#

| Название парсера | Описание |

|---|---|

| SE::Google | Парсинг всех данных с поисковой выдачи Google: ссылки, анкоры, сниппеты, Related keywords, парсинг рекламных блоков. Многопоточность, обход ReCaptcha |

| SE::Yandex | Парсинг всех данных с поисковой выдачи Yandex: ссылки, анкоры, сниппеты, Related keywords, парсинг рекламных блоков. Максимальная глубина парсинга |

| SE::AOL | Парсинг всех данных с поисковой выдачи AOL: ссылки, анкоры, сниппеты |

| SE::Bing | Парсинг всех данных с поисковой выдачи Bing: ссылки, анкоры, сниппеты, Related keywords, Максимальная глубина парсинга |

| SE::Baidu | Парсинг всех данных с поисковой выдачи Baidu: ссылки, анкоры, сниппеты, Related keywords |

| SE::Baidu | Парсинг всех данных с поисковой выдачи Baidu: ссылки, анкоры, сниппеты, Related keywords |

| SE::Dogpile | Парсинг всех данных с поисковой выдачи Dogpile: ссылки, анкоры, сниппеты, Related keywords |

| SE::DuckDuckGo | Парсинг всех данных с поисковой выдачи DuckDuckGo: ссылки, анкоры, сниппеты |

| SE::MailRu | Парсинг всех данных с поисковой выдачи MailRu: ссылки, анкоры, сниппеты |

| SE::Seznam | Парсер чешской поисковой системы seznam.cz: ссылки, анкоры, сниппеты, Related keywords |

| SE::Yahoo | Парсинг всех данных с поисковой выдачи Yahoo: ссылки, анкоры, сниппеты, Related keywords, Максимальная глубина парсинга |

| SE::Youtube | Парсинг данных с поисковой выдачи Youtube: ссылки, название, описание, имя пользователя, ссылка на превью картинки, кол-во просмотров, длина видеоролика |

| SE::Ask | Парсер американской поисковой выдачи Google через Ask.com: ссылки, анкоры, сниппеты, Related keywords |

| SE::Rambler | Парсинг всех данных с поисковой выдачи Rambler: ссылки, анкоры, сниппеты |

| SE::Startpage | Парсинг всех данных с поисковой выдачи Startpage: ссылки, анкоры, сниппеты |

Результаты#

https://techcrunch.com/wp-content/uploads/2015/04/codecode.jpg

https://specials-images.forbesimg.com/imageserve/5f302109ffad89f9130e07db/960×0.jpg?cropX1=0&cropX2=4800&cropY1=243&cropY2=2943

https://victoria.mediaplanet.com/app/uploads/sites/102/2019/07/mainimage-26.jpg

https://inteng-storage.s3.amazonaws.com/img/iea/9lwjAVnM6E/sizes/ocde_resize_md.jpg

https://miro.medium.com/max/11520/0*Jy3heMl_yP_fQwMO

https://cdn-images.welcometothejungle.com/5DDbrp9_kdlw05Z0hzc7kYEpaaruHhUUWJqs-nW1o8k/rs:auto:980::/q:85/czM6Ly93dHRqLXByb2R1Y3Rpb24vdXBsb2Fkcy9jYXRlZ29yeS9jb3Zlci8yNjYwLzE1NDg4My9jb2xsZWN0aW9uX2NhdGVnb3J5X2JlaGluZF90aGVfY29kZS5qcGc

https://code.org/shared/images/social-media/codeorg2020_social.png

https://miro.medium.com/max/12032/0*ghyQGW_ZCFN_afQ0

https://www.ionos.com/digitalguide/fileadmin/DigitalGuide/Teaser/code-editoren-t.jpg

Скопировать

Парсеры сайтов в зависимости от используемой технологии

Парсеры на основе Python и PHP

Такие парсеры создают программисты. Без специальных знаний сделать парсер самостоятельно не получится. На сегодня самый популярный язык для создания таких программ Python. Разработчикам, которые им владеют, могут быть полезны:

- библиотека Beautiful Soup;

- фреймворки с открытым исходным кодом Scrapy, Grab и другие.

Заказывать разработку парсера с нуля стоит только для нестандартных задач. Для большинства целей можно подобрать готовые решения.

Парсеры-расширения для браузеров

Парсить данные с сайтов могут бесплатные расширения для браузеров. Они извлекают данные из html-кода страниц при помощи языка запросов Xpath и выгружают их в удобные для дальнейшей работы форматы — XLSX, CSV, XML, JSON, Google Таблицы и другие. Так можно собрать цены, описания товаров, новости, отзывы и другие типы данных.

Примеры расширений для Chrome: Parsers, Scraper, Data Scraper, kimono.

Парсеры сайтов на основе Excel

В таких программах парсинг с последующей выгрузкой данных в форматы XLS* и CSV реализован при помощи макросов — специальных команд для автоматизации действий в MS Excel. Пример такой программы — ParserOK. Бесплатная пробная версия ограничена периодом в 10 дней.

Парсинг при помощи Google Таблиц

В Google Таблицах парсить данные можно при помощи двух функций — importxml и importhtml.

Функция IMPORTXML импортирует данные из источников формата XML, HTML, CSV, TSV, RSS, ATOM XML в ячейки таблицы при помощи запросов Xpath. Синтаксис функции:

IMPORTXML("https://site.com/catalog"; "//a/@href")

IMPORTXML(A2; B2)

Расшифруем: в первой строке содержится заключенный в кавычки url (обязательно с указанием протокола) и запрос Xpath.

Знание языка запросов Xpath для использования функции не обязательно, можно воспользоваться опцией браузера «копировать Xpath»:

Вторая строка указывает ячейки, куда будут импортированы данные.

IMPORTXML можно использовать для сбора метатегов и заголовков, количества внешних ссылок со страницы, количества товаров на странице категории и других данных.

У IMPORTHTML более узкий функционал — она импортирует данные из таблиц и списков, размещенных на странице сайта. Синтаксис функции:

IMPORTHTML("https://https://site.com/catalog/sweets"; "table"; 4)

IMPORTHTML(A2; B2; C2)

Расшифруем: в первой строке, как и в предыдущем случае, содержится заключенный в кавычки URL (обязательно с указанием протокола), затем параметр «table», если хотите получить данные из таблицы, или «list», если из списка. Числовое значение (индекс) означает порядковый номер таблицы или списка в html-коде страницы.

Популярные парсеры для SEO

PromoPult

Данный парсер метатегов и заголовков позволяет убрать дубли метатегов, а также выявить неинформативные заголовки, будучи особо полезным при анализе SEO конкурентов. Первые пятьсот запросов – бесплатно, а далее придется заплатить 0,01 рубля за запрос при объеме от десяти тысяч.

Работа сервиса происходит «в облаке», а для начала потребуется добавить список URL и указать страницы, парсинг которых следует осуществить. Благодаря данному парсеру можно проанализировать ключевые слова, используемые конкурентами с целью оптимизации страниц сайта, а также изучить, как происходит формирование заголовков.

Предназначен для комплексного анализа сайтов, что позволяет провести анализ основных SEO-параметров, осуществить технический анализ сайта, а также импортировать данные как из Google Аналитики, так и Яндекс.Метрики. Предоставляется тестовый период длительностью в 14 дней, а стоимость начинается от 19 долларов в месяц.

Screaming Frog SEO Spider

Данный парсер является идеальным решением для любых SEO-задач. Лицензию на год можно приобрести за 149 фунтов, однако есть и бесплатная версия, отличающаяся ограниченным функционалом, в то время как количество URL для парсинга не может превышать отметку в пятьсот.

ComparseR

С помощью данного десктопного парсера можно выявить страницы, которые обходит поисковый робот во время сканирования сайта, а также провести технический анализ портала. Есть демоверсия с некоторыми ограничениями, а лицензию можно приобрести за две тысячи рублей.

Анализ от PR-CY

Представляет собой онлайн-ресурс для анализа сайтов по достаточно подробному списку параметров. Минимальный тариф составляет 990 рублей в месяц, а тестирование, с полным доступом к функционалу, можно провести в течение семи дней.

Анализ от SE Ranking

Стоимость минимального тарифа данного облачного сервиса составляет от семи долларов в месяц, при оформлении годовой подписки, причем возможна как подписка, так и оплата за каждую проверку. Сервис позволяет проверить скорость загрузки страниц, проанализировать метатеги. Выявить технические ошибки, а также провести анализ внутренних ссылок.

Xenu`s Link Sleuth

Данный бесплатный десктопный парсер предназначен для Windows и используется для парсинга всех URL, имеющихся на сайте, а также применяется с целью обнаружения неработающих ссылок.

Представляет собой SEO-комбайн, отличающийся многофункциональностью, причем минимальный тарифный план лицензии, носящей пожизненный характер, составляет 119 долларов, в то время как максимальный – 279. Демоверсия присутствует. Данный инструмент позволяет осуществить парсинг ключевых слов и провести мониторинг позиций, занимаемых сайтом в поисковых системах.

Парсеры сайтов по способу доступа к интерфейсу

Облачные парсеры

Облачные сервисы не требуют установки на ПК. Все данные хранятся на серверах разработчиков, вы скачиваете только результат парсинга. Доступ к программному обеспечению осуществляется через веб-интерфейс или по API.

Примеры облачных парсеров с англоязычным интерфейсом:

- http://import.io/,

- Mozenda (есть также ПО для установки на компьютер),

- Octoparce,

- ParseHub.

Примеры облачных парсеров с русскоязычным интерфейсом:

- Xmldatafeed,

- Диггернаут,

- Catalogloader.

У всех сервисов есть бесплатная версия, которая ограничена или периодом использования, или количеством страниц для сканирования.

Программы-парсеры

ПO для парсинга устанавливается на компьютер. В подавляющем большинстве случаев такие парсеры совместимы с ОС Windows. Обладателям mac OS можно запускать их с виртуальных машин. Некоторые программы могут работать со съемных носителей.

Примеры парсеров-программ:

- ParserOK,

- Datacol,

- SEO-парсеры — Screaming Frog, ComparseR, Netpeak Spider и другие.

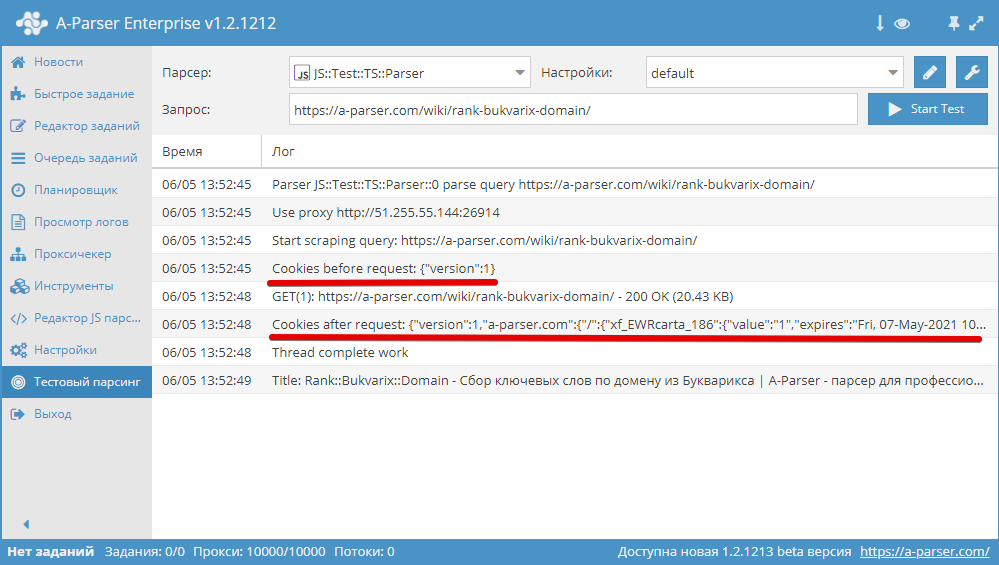

Работа с cookies для текущего запроса

Получение массива cookies

awaitthis.cookies.getAll();

Скопировать

Установка cookies, в качестве аргумента должен быть передан массив с cookies

asyncparse(set, results){

this.logger.put(«Start scraping query: «+set.query);

awaitthis.cookies.setAll(‘test_1=1′,’test_2=2’);

let cookies =awaitthis.cookies.getAll();

this.logger.put(«Cookies: «+JSON.stringify(cookies));

results.SKIP=1;

return results;

}

Скопировать

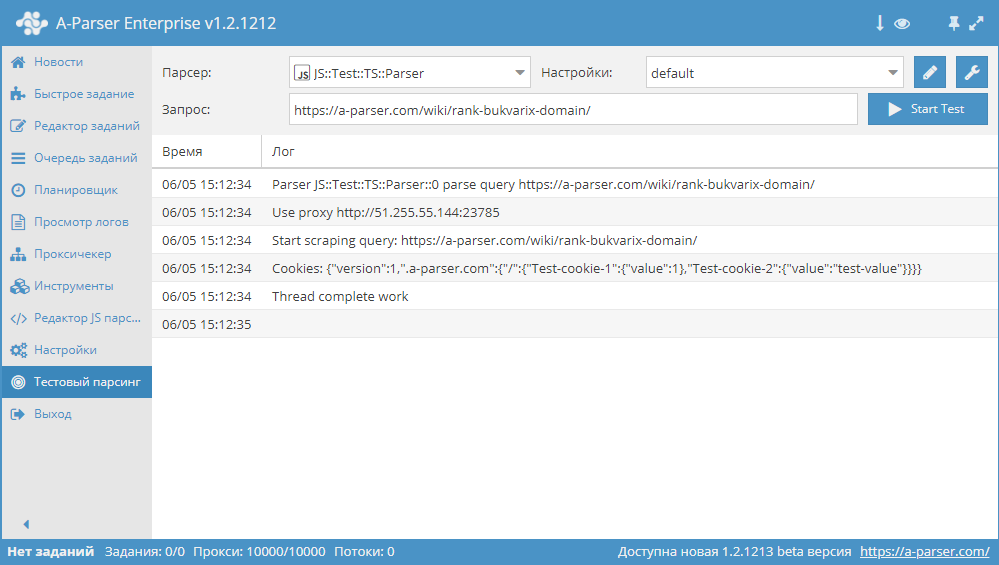

— установка одиночного cookie

asyncparse(set, results){

this.logger.put(«Start scraping query: «+set.query);

awaitthis.cookies.set(‘.a-parser.com’,’/’,’Test-cookie-1′,1);

awaitthis.cookies.set(‘.a-parser.com’,’/’,’Test-cookie-2′,’test-value’);

let cookies =awaitthis.cookies.getAll();

this.logger.put(«Cookies: «+JSON.stringify(cookies));

results.SKIP=1;

return results;

}

Скопировать

Проблема урлов картинок и ссылок

Как вам должно быть известно, существуют абсолютные пути и относительные. Пример: ссылка http://site.ru/folder/subfolder/page.html — абсолютная, а ссылка folder/subfolder/page.html — относительная.

Учтите, что то, куда ведет относительная ссылка, зависит от той страницы, где она расположена. Давайте разберемся более подробнее.

Пример: мы парсим страницу сайта, url страницы http://site.ru/folder/subfolder/index.html.

На этой странице расположена картинка src=»https://steptosleep.ru/wp-content/uploads/2018/06/77270.png». В этом случае реальный абсолютный путь к картинке такой: http://site.ru/folder/subfolder/image.png. Давайте разберем все возможные варианты.

Пусть url страницы http://site.ru/folder/subfolder/index.html. На этой странице расположена картинка src=»https://steptosleep.ru/wp-content/uploads/2018/06/75516.png» — с начальным слешем (эта ссылка тоже абсолютная, только без http в начале). В этом случае реальный абсолютный путь к картинке такой: http://site.ru/image.png.

Пусть url страницы http://site.ru/folder/subfolder/index.html. На этой странице расположена картинка src=»https://steptosleep.ru/wp-content/uploads/2018/06/59157.png».

В этом случае реальный абсолютный путь к картинке такой: http://site.ru/folder/subfolder/images/image.png.

Пусть url страницы http://site.ru/folder/subfolder/index.html. На этой странице расположена картинка src=»https://steptosleep.ru/wp-content/uploads/2018/06/45053.png». В этом случае реальный абсолютный путь к картинке такой: http://site.ru/images/image.png.

Пусть url страницы http://site.ru/folder/subfolder/index.html. На этой странице расположена картинка src=»https://steptosleep.ru/wp-content/uploads/2018/06/7676.png». В этом случае реальный абсолютный путь к картинке такой: http://site.ru/folder/image.png, так как конструкция ../ поднимает нас на папку выше.

Пусть url страницы http://site.ru/folder/subfolder/index.html. На этой странице расположена картинка src=»https://steptosleep.ru/wp-content/uploads/2018/06/41032.png». В этом случае реальный абсолютный путь к картинке такой: http://site.ru/image.png, так как конструкция ../../ поднимает нас на две папки выше.

Пусть url страницы http://site.ru/folder/subfolder/index.html. На этой странице расположена картинка src=»https://steptosleep.ru/wp-content/uploads/2018/06/80277.png». В этом случае реальный абсолютный путь к картинке такой: http://site.ru/folder/image.png, так как конструкция ../ поднимает нас на две папки выше.

Думаю, вам понятно, что в данном случае разницы между картинками и ссылками никакой нет — все пути строятся одинаково. То же самое относится к путям к CSS файлам, если они вам вдруг понадобятся (всякое бывает).

В общем, я думаю, общая логика ясна.

Виды парсеров по технологии

Браузерные расширения

Для парсинга данных есть много браузерных расширений, которые собирают нужные данные из исходного кода страниц и позволяют сохранять в удобном формате (например, в XML или XLSX).

Парсеры-расширения — хороший вариант, если вам нужно собирать небольшие объемы данных (с одной или парочки страниц). Вот популярные парсеры для Google Chrome:

- Parsers;

- Scraper;

- Data Scraper;

- Kimono.

Надстройки для Excel

Программное обеспечение в виде надстройки для Microsoft Excel. Например, ParserOK. В подобных парсерах используются макросы — результаты парсинга сразу выгружаются в XLS или CSV.

Google Таблицы

С помощью двух несложных формул и Google Таблицы можно собирать любые данные с сайтов бесплатно.

Эти формулы: IMPORTXML и IMPORTHTML.

IMPORTXML

Функция использует язык запросов XPath и позволяет парсить данные с XML-фидов, HTML-страниц и других источников.

Вот так выглядит функция:

Функция принимает два значения:

- ссылку на страницу или фид, из которого нужно получить данные;

- второе значение — XPath-запрос (специальный запрос, который указывает, какой именно элемент с данными нужно спарсить).

Хорошая новость в том, что вам не обязательно изучать синтаксис XPath-запросов. Чтобы получить XPath-запрос для элемента с данными, нужно открыть инструменты разработчика в браузере, кликнуть правой кнопкой мыши по нужному элементу и выбрать: Копировать → Копировать XPath.

С помощью IMPORTXML можно собирать практически любые данные с html-страниц: заголовки, описания, мета-теги, цены и т.д.

IMPORTHTML

У этой функции меньше возможностей — с ее помощью можно собрать данные из таблиц или списков на странице. Вот пример функции IMPORTHTML:

Она принимает три значения:

- Ссылку на страницу, с которой необходимо собрать данные.

- Параметр элемента, который содержит нужные данные. Если хотите собрать информацию из таблицы, укажите «table». Для парсинга списков — параметр «list».

- Число — порядковый номер элемента в коде страницы.

async processConf?(conf)#

Данный метод используется для преобразования конфига по каким либо правилам, например при использовании каптчи нам всегда необходимо использовать сессии:

asyncprocessConf(conf){

if(conf.useCaptcha)

conf.useSessions=1

}

asyncparse(set, results){

if(conf.useSessions)

awaitthis.login();

}

Скопировать

Существование данного метода обусловлено тем что A-Parser поддерживает динамические поля конфига и в рамках одного задания конфиг может иметь разные значения, такой сценарий возможен в 2ух случаях:

- Использование шаблонов в полях конфигурации, например для поля

- Использование при вызове одного парсера из другого()

Метод вызывается однократно перед . Для случаев описанных выше вызывается дополнительно перед обработкой() каждого запроса

Основные правила применения :

- Используйте только если преобразования конфига имеет эффект на производительность

- Имейте ввиду что выполняется один раз, а может выполняться для каждого запроса, в этом случае может быть нарушена логика, если зависит от изменяющихся полей конфига(см. ниже)

Парсинг – что это значит и как парсить сайты?

Привет, ребят. Опережая события, хочу предупредить, что для того, чтобы парсить сайты необходимо владеть хотя бы php. У меня есть интересная статья о том, как стать php программистом. И все же, что такое парсинг?

Начнем с определения. В этой статье речь пойдет о парсинге сайтов. Попробую объяснить как можно проще и доходчивее.

Парсинг, что это значит: слово понятное дело пришло от английского parse -по факту это означает разбор содержимого страницы на отдельные составляющие. Этот процесс происходит автоматически благодаря специальным программам (парсеров).

В пример парсера можно привести поисковые системы. Их роботы буквально считывают информацию с сайтов, хранят данные об их содержимом в своих базах и когда вы вбиваете поисковой запрос они выдают самые подходящие и актуальные сайты.

Парсинг? Зачем он нужен?

Представьте себе, что вы создали сайт, не одностраничный продающий сайт, а крупный портал с множеством страниц. У Вас есть красивый дизайн, панель управления и возможно даже разделы, которые вы хотите видеть, но где взять информацию для наполнения сайта?

В интернете – где ж еще. Однако не все так просто.

Приведу в пример лишь 2 проблемы при наполнении сайта контентом:

- Серьезный объём информации. Если Вы хотите обойти конкурентов, хотите чтобы Ваш ресурс был популярен и успешен, Вам просто необходимо публиковать огромное количество информации на своем ресурсе. Сегодняшняя тенденция показывает, что контента нужно больше чем возможно заполнить вручную.

- Постоянные обновления. Информацию которая все время меняется и которой как мы уже сказали большие объемы, невозможно обновлять вовремя и обслуживать. Некоторые типы информации меняются ежеминутно и обновлять её руками невозможно и не имеет смысла.

И тут нам приходит на помощь старый добрый парсинг! Та-дааааам!Это самое оптимальное решение, чтобы автоматизировать процесс изменения и сбора контента.

- быстроизучит тысячи сайтов;

- аккуратно отделит нужную информацию от программного кода;

- безошибочновыберет самые сливки и выкинет ненужное;

- эффективносохранит конечный результат в нужном виде.

Тут я буду краток, скажу лишь, что для этого можно использовать практически любой язык программированию, который мы используем при разработке сайтов. Это и php, и C++, и python и т.д.

Поскольку наиболее распространенным среди веб-разработчиков является php, хочу поделиться с Вами сайтом, на котором очень доступно объясняется как парсить сайты при помощи php скрипта http://agubtor.autoorder.biz/l/m2

Поскольку мой проект тоже совсем молодой, я хочу попробовать этот метод.

Ах да, чуть не забыл. Как всегда, для тех кто хочет разобраться в теме до уровня мастерства, вот ссылка на описание видеокурса http://agubtor.autoorder.biz/l/m3

А что Вы думаете об автоматизации сбора информации? Действительно ли без этого не обойтись или лучше наполнять сайт настоящим эксклюзивным контентом?

Виды парсеров по сферам применения

Для организаторов СП (совместных покупок)

Есть специализированные парсеры для организаторов совместных покупок (СП). Их устанавливают на свои сайты производители товаров (например, одежды). И любой желающий может прямо на сайте воспользоваться парсером и выгрузить весь ассортимент.

Чем удобны эти парсеры:

- интуитивно понятный интерфейс;

- возможность выгружать отдельные товары, разделы или весь каталог;

- можно выгружать данные в удобном формате. Например, в Облачном парсере доступно большое количество форматов выгрузки, кроме стандартных XLSX и CSV: адаптированный прайс для Tiu.ru, выгрузка для Яндекс.Маркета и т. д.

Популярные парсеры для СП:

- SPparser.ru,

- Облачный парсер,

- Турбо.Парсер,

- PARSER.PLUS,

- Q-Parser.

Вот три таких инструмента:

- Marketparser,

- Xmldatafeed,

- ALL RIVAL.

Парсеры для быстрого наполнения сайтов

Такие сервисы собирают названия товаров, описания, цены, изображения и другие данные с сайтов-доноров. Затем выгружают их в файл или сразу загружают на ваш сайт. Это существенно ускоряет работу по наполнению сайта и экономят массу времени, которое вы потратили бы на ручное наполнение.

В подобных парсерах можно автоматически добавлять свою наценку (например, если вы парсите данные с сайта поставщика с оптовыми ценами). Также можно настраивать автоматический сбор или обновление данных по расписания.

Примеры таких парсеров:

- Catalogloader,

- Xmldatafeed,

- Диггернаут.

Зачем нужны парсеры

Парсер — это программа, сервис или скрипт, который собирает данные с указанных веб-ресурсов, анализирует их и выдает в нужном формате.

С помощью парсеров можно делать много полезных задач:

Для справки. Есть еще серый парсинг. Сюда относится скачивание контента конкурентов или сайтов целиком. Или сбор контактных данных с агрегаторов и сервисов по типу Яндекс.Карт или 2Гис (для спам-рассылок и звонков). Но мы будем говорить только о белом парсинге, из-за которого у вас не будет проблем.

Где взять парсер под свои задачи

Есть несколько вариантов:

- Оптимальный — если в штате есть программист (а еще лучше — несколько программистов). Поставьте задачу, опишите требования и получите готовый инструмент, заточенный конкретно под ваши задачи. Инструмент можно будет донастраивать и улучшать при необходимости.

- Воспользоваться готовыми облачными парсерами (есть как бесплатные, так и платные сервисы).

- Десктопные парсеры — как правило, программы с мощным функционалом и возможностью гибкой настройки. Но почти все — платные.

- Заказать разработку парсера «под себя» у компаний, специализирующихся на разработке (этот вариант явно не для желающих сэкономить).

Первый вариант подойдет далеко не всем, а последний вариант может оказаться слишком дорогим.

Что касается готовых решений, их достаточно много, и если вы раньше не сталкивались с парсингом, может быть сложно выбрать. Чтобы упростить выбор, мы сделали подборку самых популярных и удобных парсеров.

Законно ли парсить данные?

В законодательстве РФ нет запрета на сбор открытой информации в интернете. Право свободно искать и распространять информацию любым законным способом закреплено в четвертом пункте 29 статьи Конституции.

Допустим, вам нужно спарсить цены с сайта конкурента. Эта информация есть в открытом доступе, вы можете сами зайти на сайт, посмотреть и вручную записать цену каждого товара. А с помощью парсинга вы делаете фактически то же самое, только автоматизированно.

Парсите страницы сайтов в структуры данных

Что такое Диггернаут и что такое диггер?

Диггернаут — это облачный сервис для парсинга сайтов, сбора информации и других ETL (Extract, Transform, Load) задач. Если ваш бизнес лежит в плоскости торговли и ваш поставщик не предоставляет вам данные в нужном вам формате, например в csv или excel, мы можем вам помочь избежать ручной работы, сэкономив ваши время и деньги!

Все, что вам нужно сделать — создать парсер (диггер), крошечного робота, который будет парсить сайты по вашему запросу, извлекать данные, нормализовать и обрабатывать их, сохранять массивы данных в облаке, откуда вы сможете скачать их в любом из доступных форматов (например, CSV, XML, XLSX, JSON) или забрать в автоматическом режиме через наш API.

Какую информацию может добывать Диггернаут?

- Цены и другую информацию о товарах, отзывы и рейтинги с сайтов ритейлеров.

- Данные о различных событиях по всему миру.

- Новости и заголовки с сайтов различных новостных агентств и агрегаторов.

- Данные для статистических исследований из различных источников.

- Открытые данные из государственных и муниципальных источников. Полицейские сводки, документы по судопроизводству, росреест, госзакупки и другие.

- Лицензии и разрешения, выданные государственными структурами.

- Мнения людей и их комментарии по определенной проблематике на форумах и в соцсетях.

- Информация, помогающая в оценке недвижимости.

- Или что-то иное, что можно добыть с помощью парсинга.

Должен ли я быть экспертом в программировании?

Если вы никогда не сталкивались с программированием, вы можете использовать наш специальный инструмент для построения конфигурации парсера (диггера) — Excavator. Он имеет графическую оболочку и позволяет работать с сервисом людям, не имеющих теоретических познаний в программировании. Вам нужно лишь выделить данные, которые нужно забрать и разместить их в структуре данных, которую создаст для вас парсер. Для более простого освоения этого инструмента, мы создали серию видео уроков, с которыми вы можете ознакомиться в документации.

Если вы программист или веб-разработчик, знаете что такое HTML/CSS и готовы к изучению нового, для вас мы приготовили мета-язык, освоив который вы сможете решать очень сложные задачи, которые невозможно решить с помощью конфигуратора Excavator. Вы можете ознакомиться с документацией, которую мы снабдили примерами из реальной жизни для простого и быстрого понимания материала.

Если вы не хотите тратить свое время на освоение конфигуратора Excavator или мета-языка и хотите просто получать данные, обратитесь к нам и мы создадим для вас парсер в кратчайшие сроки.

Возможные настройки#

important

| Параметр | Значение по умолчанию | Описание |

|---|---|---|

| Pages count | 10 | Количество страниц для парсинга |

| Google domain | www.google.com | Домен Гугла для парсинга, поддерживаются все домены |

| Results language | Auto (Based on IP) | Выбор языка результатов(параметр lr=) |

| Search from country | Auto (Based on IP) | Выбор страны откуда осуществляется поиск(гео-зависимый поиск, параметр gl=) |

| Interface language | English | Возможность выбора языка интерфейса Google, для максимальной идентичности результатов в парсере и в браузере |

| Size | Any size | Выбор размера изображений |

| Color | Any color | Выбор цвета изображений |

| Usage rights | Not filtered by license | Лицензия на использование изображений |

| Type | Any type | Выбор типа изображений |

| Serp time | All time | Время серпа (временно-зависимый поиск, параметр tbs=) |

| Util::ReCaptcha2 preset | default | Пресет парсера Util::ReCaptcha2 Util::ReCaptcha2 Необходимо предварительно настроить парсер Util::ReCaptcha2 — указать свой ключ доступа и другие параметры, после чего выбрать созданный пресет здесь |

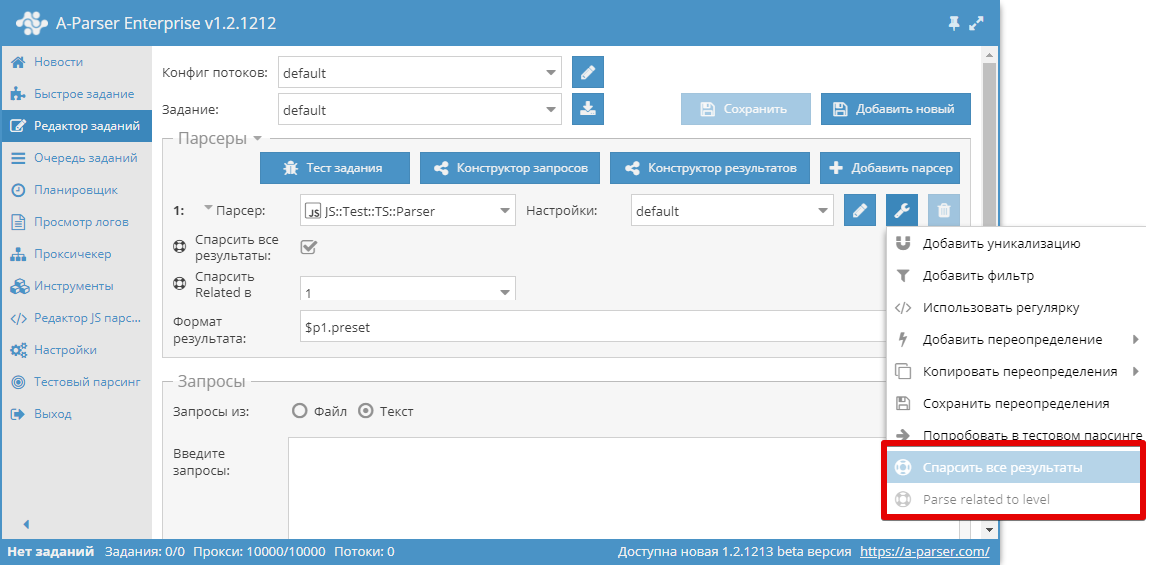

static parserOptions#

является альтернативным вариантом задания настроек, список опций отображается как дополнительные пункты в контекстном меню парсера

Декларирование опций работает аналогично :

static parserOptions

fieldNamestring,

menuTitlestring,

fieldConfig

fieldType’textfield’|’combobox’|’checkbox’,

fieldLabelstring,

fieldOptions?{},

…fieldValuesfieldValueany, valueTitlestring

;

Скопировать

Пример:

static parserOptionstypeofBaseParser.parserOptions=

‘parseAll’,’Parse all results’,

‘checkbox’,’Parse all results’

,

‘parseLevel’,’Parse related to level’,

‘combobox’,’Parse Related to level’,1,1,2,2,3,3

,

;

Скопировать